IBM yapay zekanın önyargılarını tespit edecek

IBM algoritmaların verdiği kararların nasıl ve neden verildiğini anlık olarak analiz edebilecek bir araç geliştirdi. Google'ın fotoğraf algoritmasının Afrika kökenli Amerikalıları "goril" olarak tanımlaması gibi örnekler, yakın gelecekte hayatın her alanında kullanılma ihtimali bulunan bu algoritmaların ne kadar önyargılı olduğunu tartışmaya açmıştı.

Getty Images-Algoritmalar ve yapay zeka, araba sigortası maliyetini hesaplamak için yaygın olarak kullanılır hale gelebilir

Getty Images-Algoritmalar ve yapay zeka, araba sigortası maliyetini hesaplamak için yaygın olarak kullanılır hale gelebilir

Dünyanın en büyük bilişim teknolojisi şirketi IBM, algoritmaların verdiği kararların nasıl ve neden verildiğini anlık olarak analiz edebilecek bir araç geliştirdi.

Google'ın fotoğraf algoritmasının Afrika kökenli Amerikalıları "goril" olarak tanımlaması gibi örnekler, yakın gelecekte hayatın her alanında kullanılma ihtimali bulunan bu algoritmaların ne kadar önyargılı olduğunu tartışmaya açmıştı.

Fairness 360 (Adalet 360) adı verilen araç, yapay zekanın önyargılara sahip olup olmadığının belirtilerini tarayarak gerekli düzenlemeler konusunda önerilerde bulunacak.

Teknoloji devleri ve diğer şirketler tarafından kullanılan algoritmaların karar verme sürecinde her zaman adil olmadığına dair endişeler son dönemde artıyor.

Örneğin bazı yüz tanıma algoritmalarının beyaz yüzleri tanırken siyah yüzleri tanıyamadığı ortaya çıkmıştı.

Bu algoritmalar artık emniyet, sigorta veya internet içerikleri gibi pek çok alanda kullanıldığı için olası bir önyargının geniş etkileri olabilir.

Algoritmalar genellikle "kara kutu" mantığına göre işliyor, yani çalışma sürecinde algoritma sahipleri hangi kararın nasıl ve neden verildiğini göremiyor.

IBM'in bulut temelli yazılımı açık kaynaklı ve algoritma geliştirmek için yaygın olarak kullanılan platformlarla uyumlu olacak.

Tüketiciler bir arayüz üzerinden algoritmaların nasıl karar verdiğini ve kararı verirken hangi faktörleri değerlendirdiğini görebilecek.

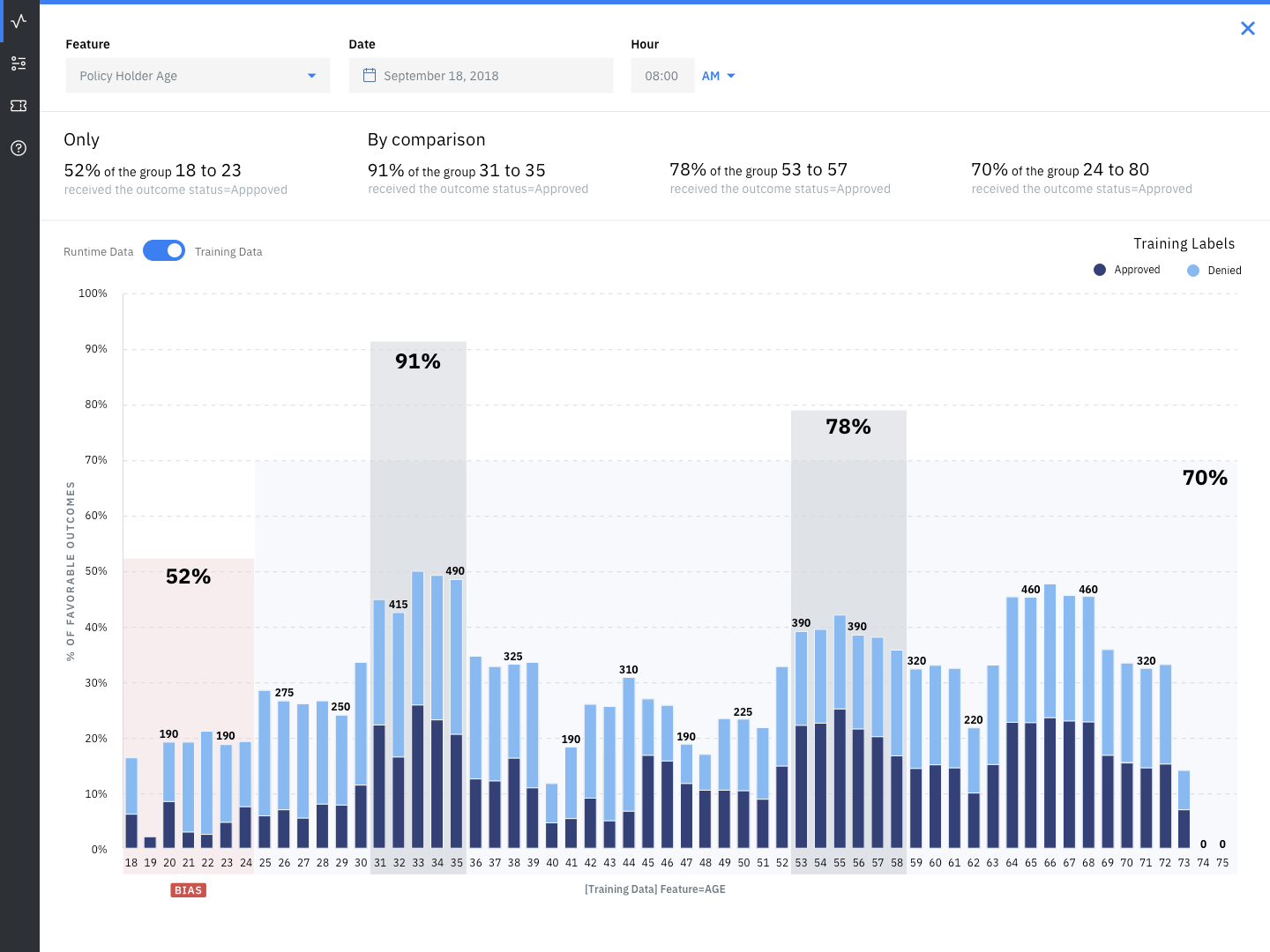

IBM-IBM'in arayüzünün bir örneği

IBM-IBM'in arayüzünün bir örneği

Algoritmanın hata oranı, performansı ve adilliği de incelenebilecek.

IBM'in Bilişsel Çözümler Birimi Başkan Yardımcısı David Kenny, "Yapay zeka kullanan ve hatalı bir kararın yaratacağı risklerle karşı karşıya olan şirketlere şeffaflık ve kontrol sağlıyoruz" diyor.

Google'ın aracı gerçek zamanlı değil

Diğer teknoloji şirketleri de aynı soruna benzer çözümler getirmek için çalışmalar yürütüyor.

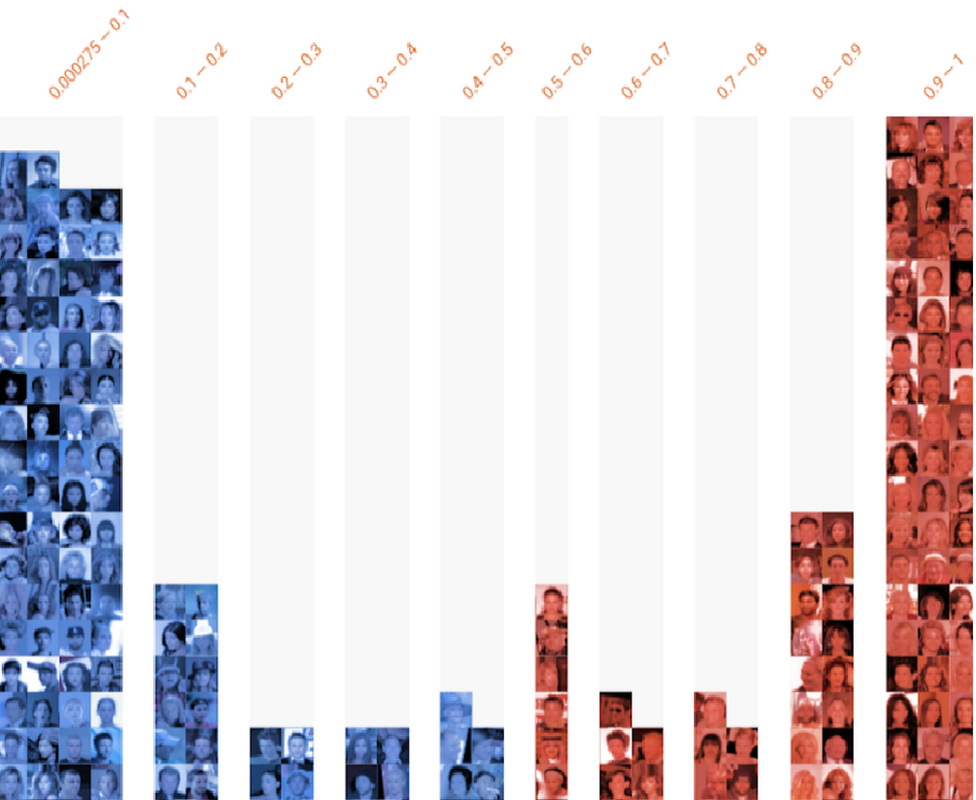

Google geçen hafta duyurduğu bir araçla kullanıcıların makine öğrenimi modellerinin nasıl çalıştığını görmesine olanak sağlamıştı.

Fakat Google'ın geliştirdiği araç gerçek zamanlı değil. Bu araç verileri zaman içinde değerlendirerek genel bir tablo sunuyor.

GoogleGoogle'ın geliştirdiği arayüzün kullanımına bir örnek olarak sunulan bu görselde gülen suratlar maviyle, gülmeyenler ise kırmızıyla işaretlenmiş

GoogleGoogle'ın geliştirdiği arayüzün kullanımına bir örnek olarak sunulan bu görselde gülen suratlar maviyle, gülmeyenler ise kırmızıyla işaretlenmiş

Makine öğrenimi ve algoritmalarda önyargı, yapay zeka topluluğunun son dönemdeki önemli gündem maddelerinden birini oluşturuyor.

Microsoft ve Facebook da benzer önyargı tespit araçlar geliştirdiklerini açıklamışlardı.

Problemin bir kısmı, algoritmaların öğrenmesi için sunulan verilerin yeterli çeşitliliğe sahip olmamasından kaynaklanıyor.

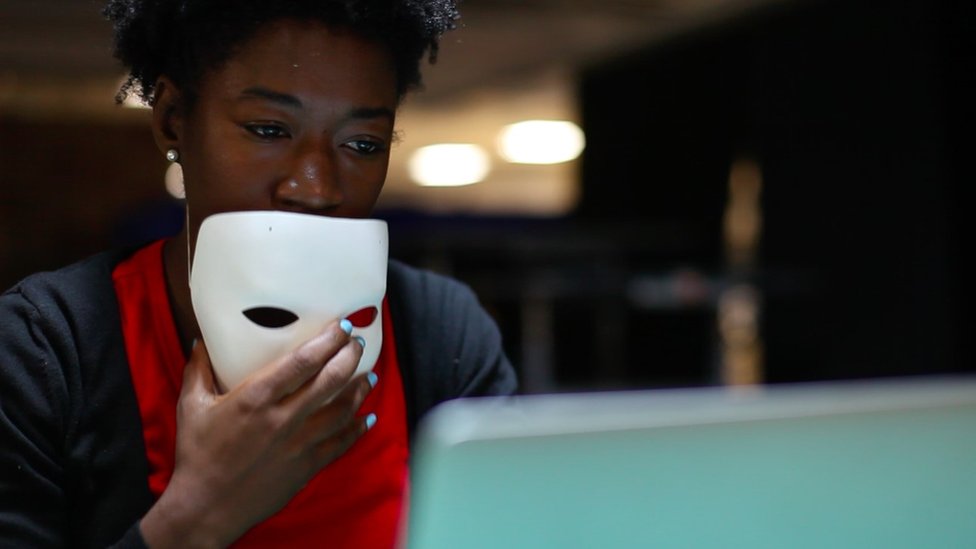

Joy Buolamwini-Joy Buolamwini yüzünü tanıyamayan bilgisayarının beyaz bir maske taktığında yüzünü tanıdığını ortaya çıkarmıştı

Joy Buolamwini-Joy Buolamwini yüzünü tanıyamayan bilgisayarının beyaz bir maske taktığında yüzünü tanıdığını ortaya çıkarmıştı

Bilgisayarının yalnızca beyaz bir maske taktığında yüzünü tanıyabildiğini fark eden Massachusetts Institute of Technology öğrencisi Joy Buolamwini , 2016'da Algoritmik Adalet Birliği (AJL) adlı bir örgüt kurmuştu.

Google, 2015 yılında fotoğraf algoritmasının Afrika kökenli Amerikalıları "goril" olarak tanımlamasının ardından, "dehşete kapıldıklarını ve içten bir şekilde özür dilediklerini" söylemişti.

2017'de de Liberty adlı insan hakları örgütü İngiltere'de polislerin, suça karışanların cezaevinde tutulup tutulmayacağına dair artan bir oranda algoritma kullanmaya başladığını, bu algoritmanın da sadece insanların yaşı, cinsiyeti ve adresini temel aldığı konusunda bir uyarı yayınlamıştı.

'Batı'da endüstriyi çeşitlendirmeliyiz'

Dünya Ekonomik Forumu'ndan Kay Firt-Butterfield, yapay zeka ve etik üzerine tartışmaların yoğunlaşmakta olduğunu söylüyor:

"Bir hukukçu olarak, algoritmaların yanlış kararlarını ortaya çıkarma yöntemleri hakkında yapılan tartışmaları gerçekten ilgi çekici buluyorum.

"Önyargıdan bahsederken ilk endişelendiğimiz konu bu algoritmaları yaratanların çoğunun genç beyaz insanlar, genelde de erkekler olması. Bu yüzden Batı'da endüstriyi daha çeşitli hale getirmemiz gerekiyor."

En Çok Okunan Haberler

-

Rus basını yazdı: Esad ailesini Rusya'da neler bekliyor?

Rus basını yazdı: Esad ailesini Rusya'da neler bekliyor?

-

Esad'a ikinci darbe

Esad'a ikinci darbe

-

Türkiye'nin 'konumu' hakkında açıklama

Türkiye'nin 'konumu' hakkında açıklama

-

İmamoğlu'ndan Erdoğan'a sert çıkış!

İmamoğlu'ndan Erdoğan'a sert çıkış!

-

Çanakkale'de korkutan deprem!

Çanakkale'de korkutan deprem!

-

Naci Görür'den korkutan uyarı

Naci Görür'den korkutan uyarı

-

Kalın Colani'nin yolcusu!

Kalın Colani'nin yolcusu!

-

Kurum, şişeyi elinin tersiyle fırlattı

Kurum, şişeyi elinin tersiyle fırlattı

-

6 asker şehit olmuştu

6 asker şehit olmuştu

-

Erdoğan'a kendi sözleriyle yanıt verdi

Erdoğan'a kendi sözleriyle yanıt verdi