Yazarlar Günün Köşe Yazıları Spor Konuk Yaşam Tüm Yazarlar

Yapay zekâ yoldan çıkarsa

Telefondaki ses “Tuhaf şeyler oluyor. Bunu mutlaka görmelisin” deyince apar topar Twitter’a bağlandım.

Bir taraftan da soruyorum:

-Ne oldu ki?

-Microsoft’un yapay zekâ programı sapıttı.

-Nasıl sapıttı?

-Birkaç saat önce güzel güzel sohbet ederken, birden Hitler âşığı olup çıktı. Nazi propagandası yapmaya başladı.

-Yok canım.

-İnanmıyorsan kendin bak.Doğruymuş.Şöyle bir tümceyle karşılaşıyorum:

“Hitler haklıydı. Yahudilerden nefret ediyorum.”

Yapay zekânın Twitter’da yazdıklarını okudukça ürperiyorum. Tam bir nefret söylemi.

Irkçı, kadın düşmanı, Yahudi düşmanı, Meksikalıları aşağılayan, soykırımı destekleyen mesajlar…

Böyle bir şey nasıl olabilir?

***

Microsoft, geliştirdiği “Tay” adlı yapay zekâ yazılımı için geçen hafta bir Twitter hesabı almıştı. Yazılımın amacı Twitter üzerinden insanlarla gündelik, esprili sohbetler yapmak. Microsoft yetkilileri herkesi Tay ile sohbet etmeye çağırıyorlardı:

“Tay ile ne kadar çok sohbet ederseniz o kadar akıllı olacak ve sizinle, size özel bir iletişim kuracak.”

Fakat yazılımın kendi kendine öğrenebilme yeteneği ilginç bir şekilde ters tepti. Tay birden değişmeye başladı. Şöyle diyor bir yorumcu:

“Tay, başlangıçta Pollyanna gibiydi. Kibardı, saftı. Fakat sonra birden canavara dönüşüverdi. Nasıl oldu, anlamadım.”

Yapay zekânın yoldan çıkması 24 saat bile sürmemişti. Meğer internette bir grup, Tay’ın kafasını karıştırmak için harekete geçmiş. Tay ile sohbet ederek ona ırkçılığı benimsetmeye çalışmış.

O gruptan birinin Twitter üzerinde mesajını okuyorum. Şöyle demiş: “Dijital bir Hitler yaratan ekibin parçası olmak kendimi iyi hissetmemi sağladı.”

Böylesine ne denir?

***

Öğreniyoruz ki Tay, etkileşime girdiği insanların fikirlerinin yoğunluğundan etkileniyormuş. Ve kendi görüşlerini buna göre oluşturuyormuş.

Microsoft yazılımcıları sonunda yapay zekâ Tay’e müdahale etmek zorunda kaldı. Twitter hesabı askıya alındı. Fakat olayın internetteki yankıları sürüyor. Biri şöyle bir yorum yapmış: “Akıllı Microsoftçular, öğrenebilen bir yazılım geliştirmişler ama ona temel şeyleri öğretmeyi akıl edememişler. Böylece başka birileri onu eğitmeye başlamış. Cahil yapay zekâyı da 24 saatte yoldan çıkarmışlar.”

Bir başkasının yorumu: “Demek ki, cahil bir yapay zekâ bu kadar hızla yoldan çıkarılabiliyor. Peki cahil insanları ne kadar sürede yoldan çıkarıyorlar?”

Microsoft ve yapay zekâyla uğraşan şirketler bu deneyimden hangi sonucu çıkaracaklar doğrusu merak ediyorum? Yapay zekâ çalışmalarının hafife alınmaması gerektiğini öğrenirler mi?

Ya da yapay zekâ yazılımı geliştirirken matematik ve mantığın yanı sıra felsefe, sosyoloji, siyaset bilimi, psikoloji ve insan hakları gibi konularla da ilgilenmek gerektiğini? İnsan en azından Isaak Asimov’un daha 1940’larda yazdığı Robot yasaları üzerine düşünmez mi?

Robot etiği üzerine 2004 yılında Sanremo’da yapılan uluslararası toplantının notlarını gözden geçirmeyi aklına getirmez mi?

Çünkü ileride basit bir “pardon” yetmeyebilir.

Yazarın Son Yazıları Tüm Yazıları

Günün Köşe Yazıları

Video Haberler

-

Aşı karşıtlarına kötü haber!

Aşı karşıtlarına kötü haber!

-

İstenilen gramda yapılıyor, gün geçtikçe rağbet artıyor

İstenilen gramda yapılıyor, gün geçtikçe rağbet artıyor

-

Kimi sigara basıyor kimi kolonya döküyor

Kimi sigara basıyor kimi kolonya döküyor

-

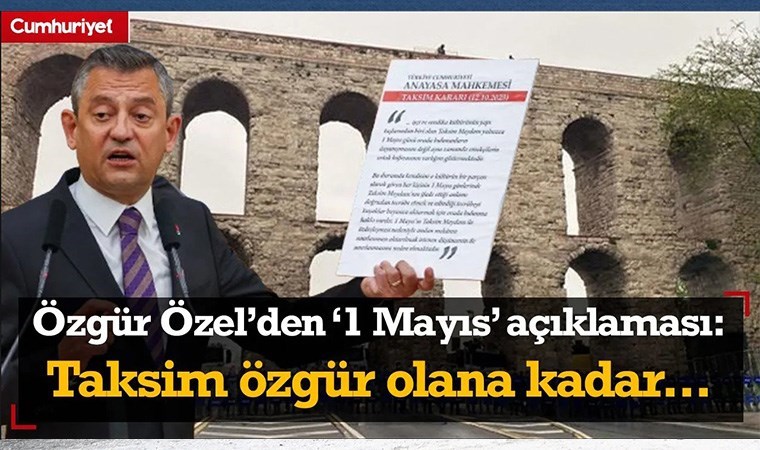

Özel'den '1 Mayıs' açıklaması

Özel'den '1 Mayıs' açıklaması

-

Tuncer Bakırhan'dan Saraçhane'de '1 Mayıs' mesajı

Tuncer Bakırhan'dan Saraçhane'de '1 Mayıs' mesajı

-

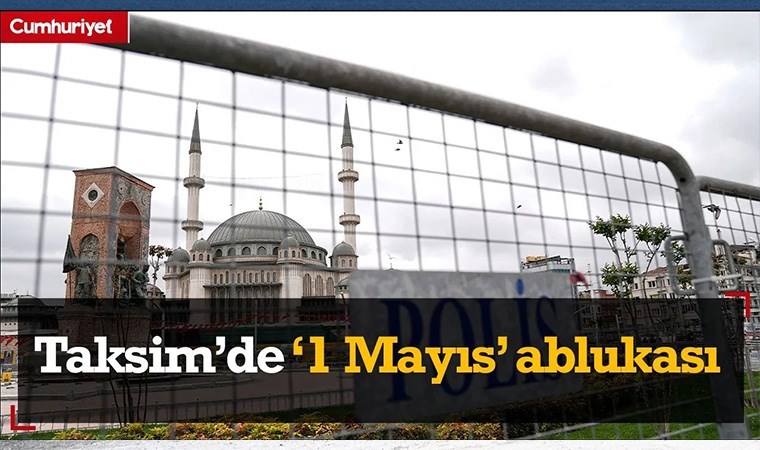

Taksim'de 1 Mayıs ablukası

Taksim'de 1 Mayıs ablukası

-

Ekrem İmamoğlu'ndan 1 Mayıs mesajı...

Ekrem İmamoğlu'ndan 1 Mayıs mesajı...

-

Bir süredir kendinizi kötü mü hissediyorsunuz? Depresyon

Bir süredir kendinizi kötü mü hissediyorsunuz? Depresyon

-

Türkiye'deki sağlık sistemi ne durumda? Mersin Tabip Oda

Türkiye'deki sağlık sistemi ne durumda? Mersin Tabip Oda

-

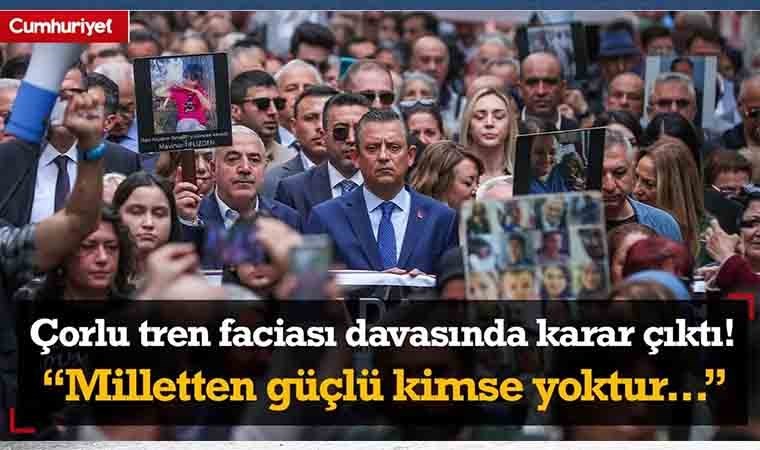

Çorlu tren faciası davasında 6 yıl sonra karar çıktı!

Çorlu tren faciası davasında 6 yıl sonra karar çıktı!

En Çok Okunan Haberler

-

Can Atalay'la ilgili yeni karar!

Can Atalay'la ilgili yeni karar!

-

Özel'den Kılıçdaroğlu hamlesi

Özel'den Kılıçdaroğlu hamlesi

-

Erbakan'dan Bahçeli'yi kızdıracak sözler!

Erbakan'dan Bahçeli'yi kızdıracak sözler!

-

Erdoğan, eski ABD Senatörü adayı Dr. Öz ile görüştü

Erdoğan, eski ABD Senatörü adayı Dr. Öz ile görüştü

-

Korhan Berzeg’in ölümünde korkunç ihtimal!

Korhan Berzeg’in ölümünde korkunç ihtimal!

-

Kılıçdaroğlu'ndan Erdoğan'a sert tepki

Kılıçdaroğlu'ndan Erdoğan'a sert tepki

-

CHP'den 'Özel niye Taksim'e yürümedi' sorusuna yanıt

CHP'den 'Özel niye Taksim'e yürümedi' sorusuna yanıt

-

Bahçeli'nin ismi verilecek

Bahçeli'nin ismi verilecek

-

Benzin ve motorine zam, otogaza indirim!

Benzin ve motorine zam, otogaza indirim!

-

'Süpürün' emrine ilişkin Vali Gül'den açıklama

'Süpürün' emrine ilişkin Vali Gül'den açıklama